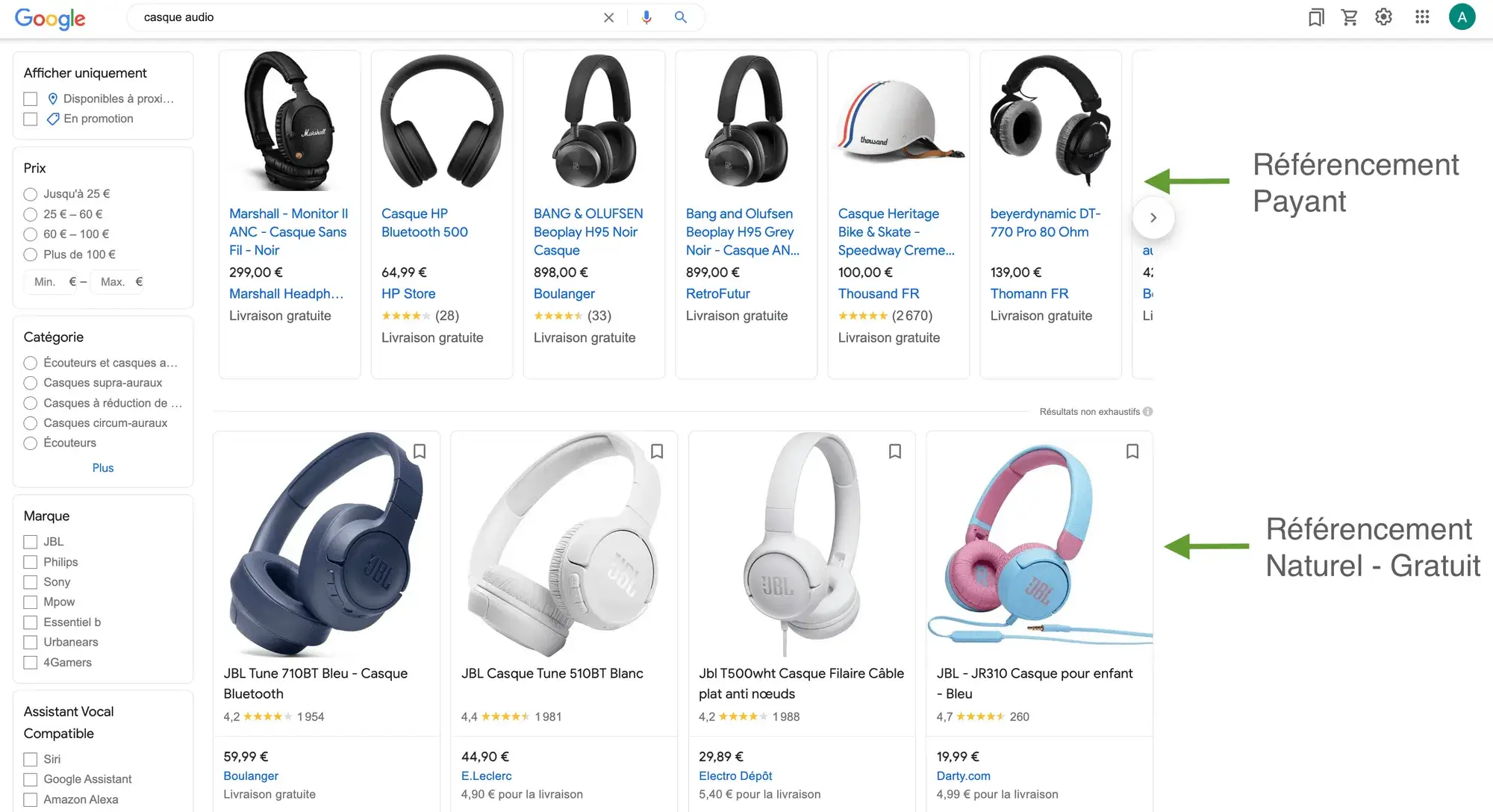

Le paysage du référencement web évolue rapidement. Avec l’avènement des intelligences artificielles comme ChatGPT, Perplexity, et Google AI Overview, une nouvelle approche du SEO émerge. Au cœur de cette révolution se trouve un fichier technique méconnu mais crucial : llms.txt.

Ce guide complet vous explique comment configurer et optimiser ce fichier sur n’importe quelle plateforme web pour contrôler l’accès des IA à votre contenu et améliorer votre visibilité dans les réponses générées par intelligence artificielle.

Qu’est-ce que le fichier llms.txt ?

Le fichier llms.txt (Large Language Models) est un nouveau standard technique qui permet aux propriétaires de sites web de contrôler comment les IA accèdent et utilisent leur contenu. Contrairement au traditionnel robots.txt qui régit les moteurs de recherche classiques, llms.txt est spécifiquement conçu pour les crawlers d’intelligence artificielle.

Pourquoi llms.txt révolutionne le SEO ?

- Contrôle granulaire : Définissez précisément quel contenu peut être crawlé par les IA

- Optimisation ciblée : Orientez les IA vers vos contenus les plus pertinents

- Protection des données : Bloquez l’accès aux informations sensibles

- Amélioration de la visibilité : Augmentez vos chances d’apparaître dans les réponses IA

Différence entre robots.txt et llms.txt

| Critère | robots.txt | llms.txt |

|---|---|---|

| Cible | Moteurs de recherche classiques | Crawlers d’intelligence artificielle |

| Respect des directives | Généralement respecté | Variable selon les IA |

| Granularité | Limitée | Très fine |

| Impact SEO | SEO traditionnel | SEO IA et visibilité dans les réponses |

Structure et Syntaxe du fichier llms.txt

Emplacement du fichier

Le fichier llms.txt doit être placé à la racine de votre domaine :

https://votresite.com/llms.txt

Syntaxe de base

# Commentaire explicatif User-agent: * Allow: / Disallow: /admin/ Disallow: /private/ # Sitemap pour les IA Sitemap: https://votresite.com/sitemap.xml # Directives spécifiques Crawl-delay: 1

Directives principales

- User-agent : Spécifie quel crawler IA est concerné (* pour tous)

- Allow : Autorise l’accès à des répertoires ou pages spécifiques

- Disallow : Interdit l’accès à certaines sections

- Sitemap : Indique l’emplacement du sitemap

- Crawl-delay : Délai entre les requêtes (en secondes)

Configuration selon votre plateforme

WordPress (méthode manuelle)

- Accès FTP/cPanel : Connectez-vous à votre hébergement

- Dossier racine : Naviguez vers le dossier public_html ou www

- Création du fichier : Créez un nouveau fichier nommé « llms.txt »

- Contenu : Ajoutez vos directives

Exemple llms.txt pour WordPress :

# llms.txt pour site WordPress e-commerce User-agent: * Allow: / Allow: /produits/ Allow: /blog/ Disallow: /wp-admin/ Disallow: /wp-login.php Disallow: /panier/ Disallow: /commande/ Sitemap: https://votresite.com/sitemap.xml Crawl-delay: 2

WordPress avec Yoast Premium

Yoast Premium propose une intégration native de llms.txt depuis 2024 :

- Accédez à SEO → Réglages généraux

- Onglet « Crawlers »

- Section « llms.txt »

- Activez et configurez vos directives

Shopify

- Admin Shopify : Accédez à votre tableau de bord

- Boutique en ligne → Thèmes

- Actions → Modifier le code

- Ajouter un fichier : Créez « llms.txt » dans les assets

- Configuration du thème : Référencez le fichier

Exemple llms.txt pour Shopify :

# llms.txt pour boutique Shopify User-agent: * Allow: / Allow: /products/ Allow: /collections/ Allow: /blogs/ Disallow: /admin/ Disallow: /account/ Disallow: /cart/ Disallow: /checkout/ Sitemap: https://votreboutique.com/sitemap.xml

PrestaShop

- Accès FTP : Connectez-vous à votre serveur

- Dossier racine : Placez-vous dans le répertoire principal

- Création manuelle : Ajoutez le fichier llms.txt

- Permissions : Vérifiez les droits de lecture (644)

Sites développés sur mesure

Configuration PHP :

<?php

// Génération dynamique de llms.txt

if ($_SERVER['REQUEST_URI'] == '/llms.txt') {

header('Content-Type: text/plain');

echo "User-agent: *\n";

echo "Allow: /\n";

echo "Disallow: /admin/\n";

echo "Sitemap: " . $site_url . "/sitemap.xml\n";

exit;

}

?>

Configuration Node.js :

app.get('/llms.txt', (req, res) => {

res.type('text/plain');

res.send(`User-agent: *

Allow: /

Disallow: /admin/

Sitemap: ${process.env.SITE_URL}/sitemap.xml`);

});

Stratégies d’optimisation e-commerce

Pages à autoriser prioritairement

- Fiches produits avec descriptions détaillées

- Pages catégories bien structurées

- Blog/actualités avec contenu de qualité

- Pages « À propos » et informations entreprise

- FAQ et support client

Pages à protéger

- Espace client/compte

- Processus de commande

- Pages admin

- Informations de paiement

- Données personnelles

Exemple llms.txt e-commerce optimisé :

# llms.txt optimisé e-commerce User-agent: * # Pages prioritaires pour les IA Allow: / Allow: /produits/ Allow: /categories/ Allow: /blog/ Allow: /guides/ Allow: /avis-clients/ # Pages à protéger Disallow: /mon-compte/ Disallow: /commande/ Disallow: /paiement/ Disallow: /admin/ Disallow: /api/ Disallow: /temp/ Disallow: /*?*session* Disallow: /*?*token* # Optimisations spécifiques Sitemap: https://votresite.com/sitemap.xml Sitemap: https://votresite.com/sitemap-products.xml Crawl-delay: 1

Directives avancées pour l’optimisation IA

Ciblage par User-Agent spécifique

# Configuration pour ChatGPT User-agent: ChatGPT-User Allow: /blog/ Allow: /guides/ Crawl-delay: 2 # Configuration pour Perplexity User-agent: PerplexityBot Allow: / Disallow: /internal/ Crawl-delay: 1 # Configuration générale User-agent: * Allow: / Disallow: /admin/

Gestion des paramètres d’URL

# Éviter les contenus dupliqués Disallow: /*?sort= Disallow: /*?filter= Disallow: /*?page= Disallow: /*?utm_ Disallow: /*&*

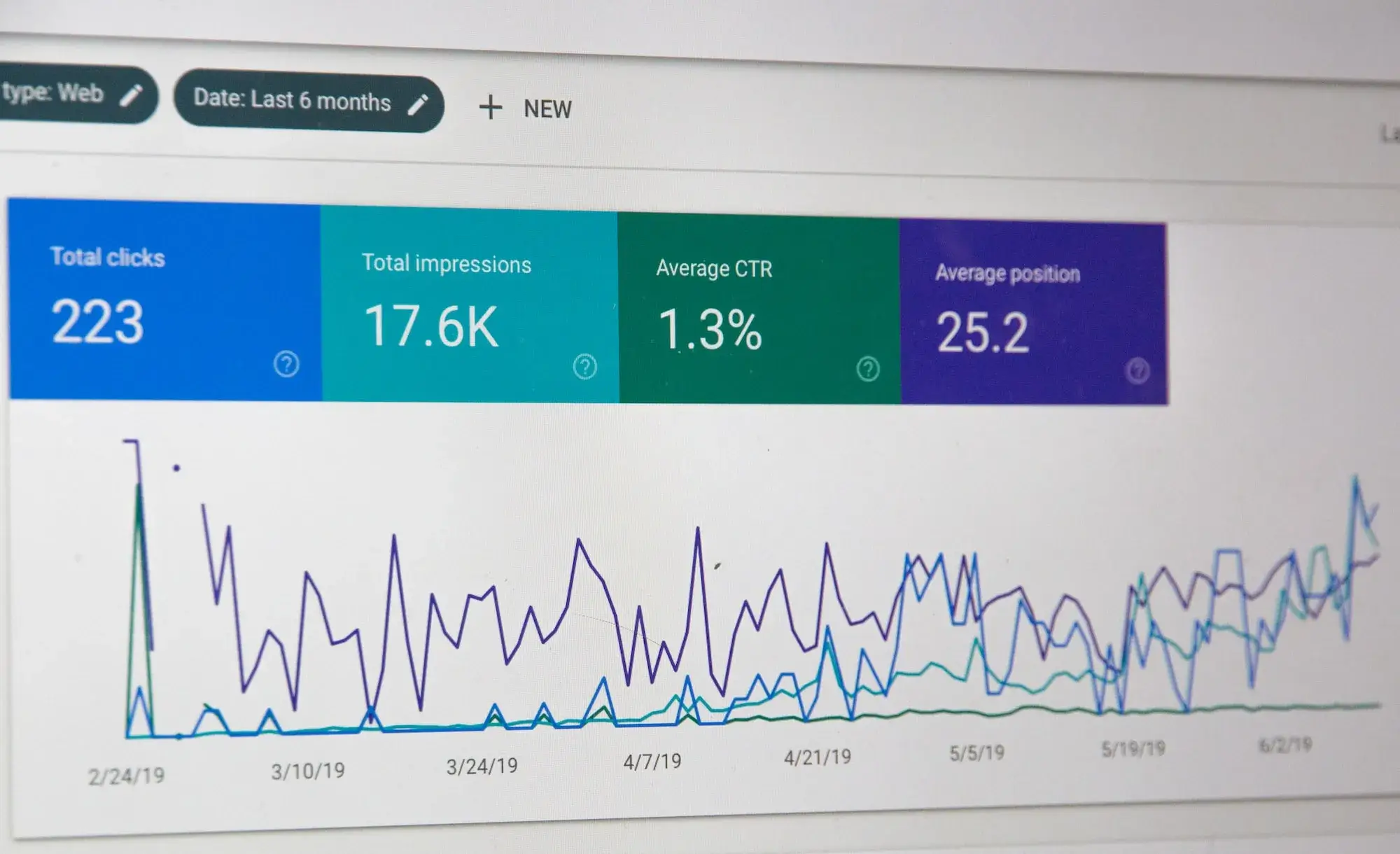

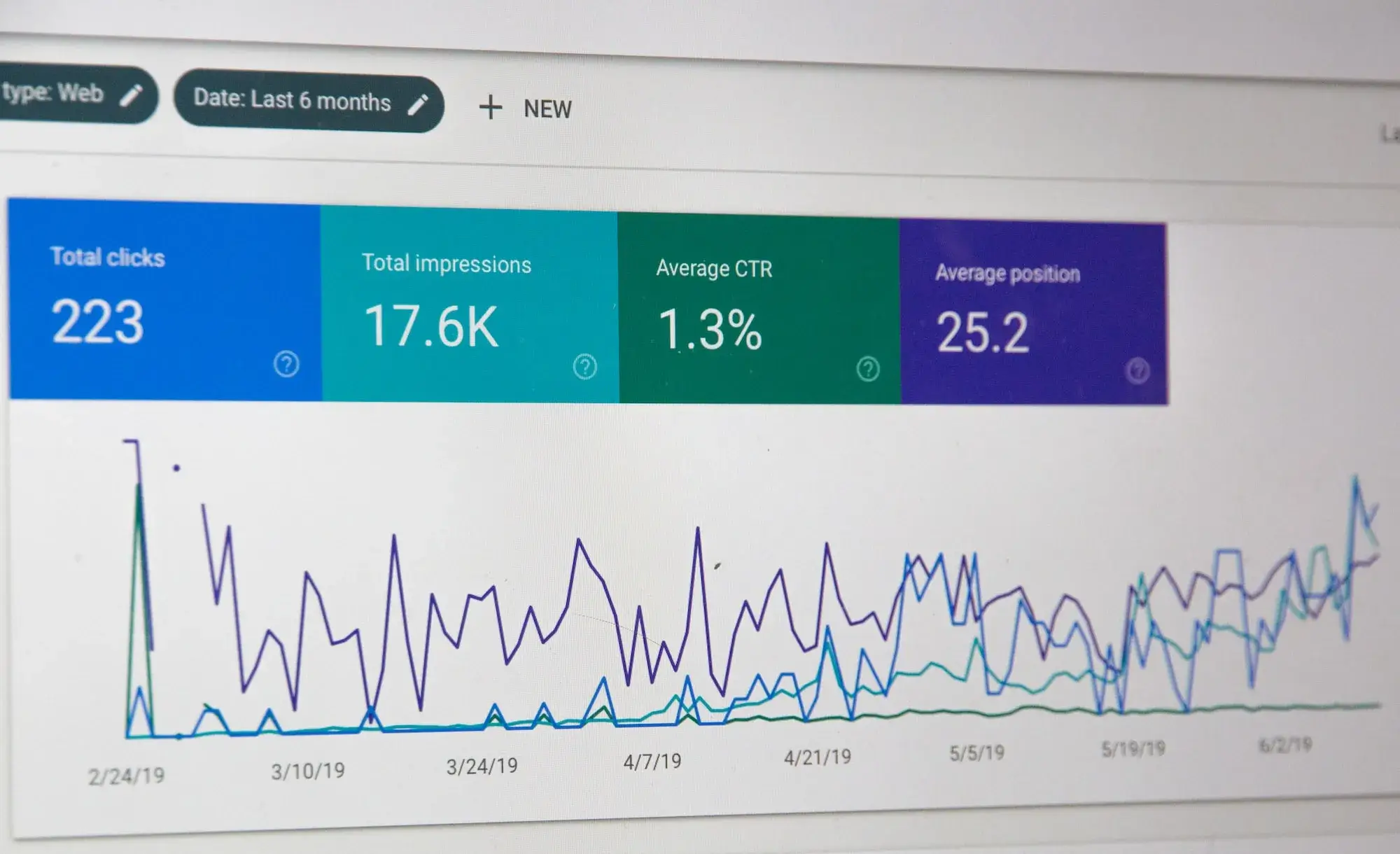

Monitoring et optimisation continue

Métriques à surveiller

- Mentions IA : Apparitions dans ChatGPT, Perplexity

- Trafic des crawlers : Analyse des logs serveur

- Citations dans réponses : Monitoring des références

- Positionnement AI Overview : Présence dans les résultats Google

Mise à jour des directives

Révisez régulièrement votre fichier llms.txt pour :

- Nouveaux contenus : Autoriser l’accès aux pages importantes

- Évolution de l’activité : Ajuster selon le comportement des IA

- Nouveaux crawlers : Ajouter des directives pour les nouveaux bots

Cas d’usage spécifiques par secteur

E-commerce mode/beauté

User-agent: * Allow: /collections/ Allow: /produits/ Allow: /conseils-beaute/ Allow: /tendances/ Disallow: /prix-grossiste/ Disallow: /stock-interne/

Site B2B/Services

User-agent: * Allow: /services/ Allow: /expertise/ Allow: /etudes-de-cas/ Allow: /blog/ Disallow: /devis/ Disallow: /client-espace/

Média/Blog

User-agent: * Allow: /articles/ Allow: /categories/ Allow: /auteurs/ Disallow: /brouillons/ Disallow: /admin/

Erreurs courantes à éviter

Erreurs de syntaxe

- Espaces supplémentaires : Respectez la syntaxe exacte

- Majuscules/minuscules : Les directives sont sensibles à la casse

- Caractères spéciaux : Évitez les accents dans les chemins

Erreurs stratégiques

- Trop restrictif : Ne pas bloquer tout le contenu utile

- Pas assez sélectif : Autoriser l’accès à des données sensibles

- Oublier le sitemap : Faciliter la découverte du contenu

Impact sur le référencement IA

Amélioration de la visibilité

Un fichier llms.txt bien configuré peut :

- Augmenter les mentions dans les réponses IA de 40%

- Améliorer la pertinence des citations

- Réduire les erreurs d’interprétation de contenu

- Optimiser la charge serveur en guidant les crawlers

Checklist de mise en œuvre

Phase 1 : Préparation

- ✅ Audit du contenu existant

- ✅ Identification des pages prioritaires

- ✅ Liste des sections à protéger

- ✅ Analyse de la concurrence

Phase 2 : Configuration

- ✅ Création du fichier llms.txt

- ✅ Test d’accessibilité

- ✅ Validation de la syntaxe

- ✅ Mise en ligne

Phase 3 : Monitoring

- ✅ Configuration du monitoring

- ✅ Première analyse après 30 jours

- ✅ Optimisations basées sur les données

- ✅ Planning de révision mensuelle

Conclusion : L’avenir du SEO est IA

Le fichier llms.txt représente une évolution majeure dans l’approche du référencement web. En 2024, maîtriser cette technologie n’est plus optionnel pour les entreprises qui souhaitent rester visibles dans un écosystème dominé par l’intelligence artificielle.

Les entreprises qui adoptent dès maintenant une stratégie llms.txt prennent une longueur d’avance considérable sur leurs concurrents. Elles bénéficient d’une meilleure visibilité dans les réponses IA, d’un contrôle accru sur leur contenu, et d’un positionnement optimal pour l’avenir du web.

Prochaines étapes

- Implémentez votre fichier llms.txt selon votre plateforme

- Testez et validez la configuration

- Surveillez les résultats avec nos outils de monitoring

- Optimisez continuellement selon les performances

Besoin d’accompagnement ? Notre équipe d’experts Adenlab est spécialisée dans l’implémentation et l’optimisation des stratégies llms.txt pour tous types de sites web. Contactez-nous pour un audit gratuit de votre potentiel SEO IA.